本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《

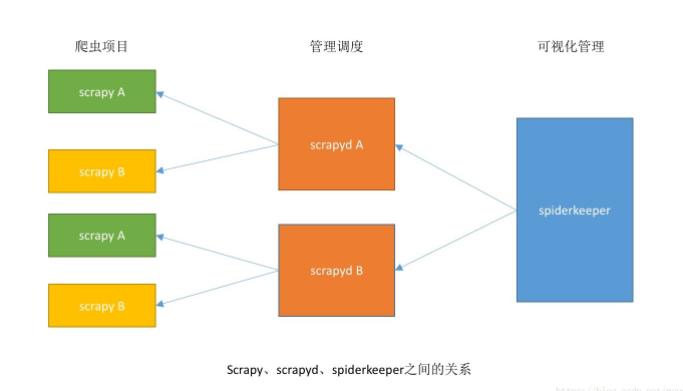

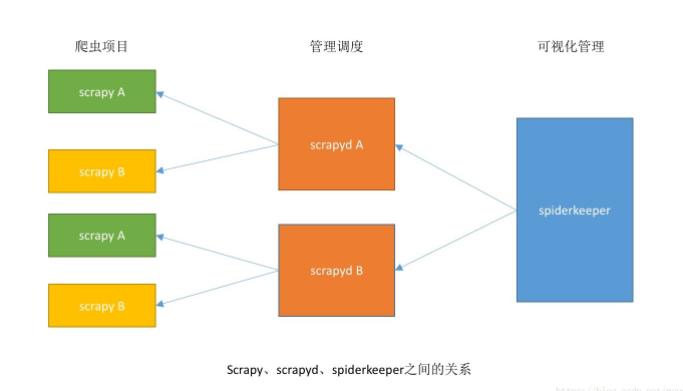

需要安装的库比较多,可以按照步骤,参看上图理解

环境准备

scrapy:

https://github.com/scrapy/scrapy

scrapyd:

https://github.com/scrapy/scrapyd

scrapyd-client:

https://github.com/scrapy/scrapyd-client

SpiderKeeper:

https://github.com/DormyMo/SpiderKeeper

安装

pip install scrapy scrapyd scrapyd-client spiderkeeper

部署项目

第一步,启动scrapyd

测试地址:http://localhost:6800/

关于scrapyd的部署安装参考:scrapy部署之scrapyd

第二步,启动SpiderKeeper

借用 SpiderKeeper 的 github 的指导(我翻译的):

命令行启动

选项:

spiderkeeper [options]

Options:

-h, --help 展示帮助信息并且退出

--host=HOST host, 默认:0.0.0.0

--port=PORT port, 默认:5000

--username=USERNAME 设置用户名 ,默认: admin

--password=PASSWORD 设置密码 ,默认: admin

--type=SERVER_TYPE 接受蜘蛛服务器类型, 默认: scrapyd

--server=SERVERS 爬虫服务器, 默认: ['http://localhost:6800']

--database-url=DATABASE_URL

SpiderKeeper 数据库,默认: sqlite:home/souche/SpiderKeeper.db

--no-auth 不进行验证

-v, --verbose 日志级别

1

SpiderKeeper可视化地址: http://localhost:5000

第三步,部署项目

1、创建项目

2、使用 scrapyd-client 生成 egg 文件 (进入需要上传的scrapy项目目录)

$ scrapyd-deploy --build-egg output.egg

3、上传 egg 文件 (确保已经启动 scrapyd 服务)

4、 完成!开始享受吧

总结

看着比较多,其实就是执行了四行语句:

安装4个包

启动scrapyd

启动spiderkeeper

打包scrapy项目

错误及解决

如果提示端口占用就参考这个文章解决:

flask的端口占用问题