解决方法参考地址

spark.read

.format("org.apache.spark.sql.execution.datasources.csv.CSVFileFormat")

.format("csv")

.option("header", "true")

.option("inferSchema", "false")

.option("delimiter", ",")

.load(csvPath)

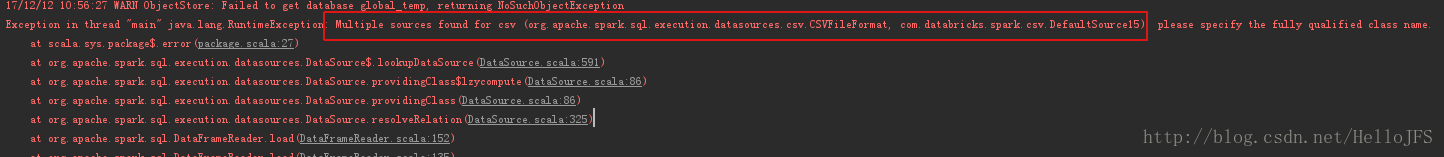

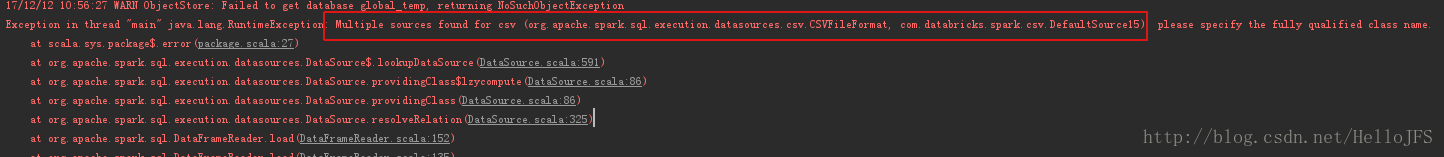

报错内容:

Multiple sources found for csv (org.apache.spark.sql.execution.datasources.csv.CSVFileFormat, com.databricks.spark.csv.DefaultSource15), please specify the fully qualified class name

解决方法:Spark 2.0后需要加入csv的完全路径:

spark

.read

.format("org.apache.spark.sql.execution.datasources.csv.CSVFileFormat")

.option("header","true")

.schema(schema)

.load(csvPath)

解决:org.apache.

spark

.sql.AnalysisException:

Multiple

source

s found for parquet (org.apache.

spark

.sql.execution.data

source

s.v2.parquet.ParquetData

Source

V2, org.apache.

spark

.sql.execution.data

source

s.parquet.ParquetFileFormat)

//配置驱动器

val

spark

Conf = new

Spark

Conf().setAppName("test").setMaster("local[2]")

val

spark

=

Spark

Session.builder().config(

spark

Conf).enableHiveSupport().getOrCreate()

//配置标题结构

val inputRddStruct = StructType(List(

StructField("DEST_COUNTRY_NAM

一开始我在

数据

质量的模块里找了半天如何创建监控任务,直到我在工作类型中看到DATA_QUALITY,我……核心配置项如下,不同的监控规则可以在

数据

质量的规则管理界面查看。

在使用

Spark

SQL时,当尝试使用MySQL中的

数据

进行写操作时,可能会遇到 org.apache.

spark

.sql.AnalysisException 无法解析的错误。在使用

Spark

SQL连接MySQL之前,首先确保已正确配置

数据

库连接参数,包括主机名、端口、用户名和密码等。当写入

数据

时,

Spark

SQL会根据表的定义和给定的

数据

进行类型匹配。请仔细检查在写操作中使用的表名和列名的拼写是否正确。请根据实际情况修改上述代码中的连接参数、

数据

路径、表名等信息,并确保已正确配置MySQL

数据

库。

1.1.1 硬软件环境

l 主机操作系统:Windows 64位,双核4线程,主频2.2G,10G内存

l 虚拟软件:VMware® Workstation 9.0.0 build-812388

l 虚拟机操作系统:CentOS6.5 64位,单核

l 虚拟机运行环境:

Ø JDK:1.7.0_55 64位

Ø Hadoop:2.2.0(需要编译为

Exception in thread "main" org.apache.

spark

.sql.AnalysisException: Since

Spark

2.3, the queries from raw JSON/

CSV

files are disallowed when the

referenced columns only include the internal corrupt record column

(named _corrupt_record b..

请先检查代码,是否遗漏了字段,也就是要解析的字段XXX不存在。如果真的漏了,补上即可,不需要再往下看了。

具体

报错

日志如下:

ApplicationMaster: User class threw exception: org.apache.

spark

.sql.AnalysisException: Resolved attribute(s) team_id#51L missing from team_id#479L, … in operator !Join

from py

spark

.sql.types import StringTypefrom py

spark

import SQLContextsqlContext = SQLContext(sc)t1 =sqlContext.read.

csv

("/user/hadoop/personalization/test1.

csv

",header=False)from py

spark

.mllib.recomm...

1、

spark

处理json格式文件:

spark

2.0之后可以直接使用

spark

session创建appname与master

创建后使用format(“json”).load(“path”)方式即可得到json文件的dataframe

val

spark

=

Spark

Session.builder().appName(“DataFrameApi”).master(“local”).getOrCreate()

val jDF=

spark

.read.format(“json”).load(“f://scala.

实验使用环境为

spark

-3.0.0-preview2,教程观看的版本为

spark

1.6,

spark

2.0开始对sql进行改进,用

spark

session实现hivecontext和sqlcontext统一,合并dataframe和datasets等,按照老的教程会引起问题。

一. SQLContext报红,找不到依赖包。

解决办法:在pom中添加依赖:

<!--导入

spark

sql依赖-->

<dependency>

<groupId>org.apache.sp